بِسْمِ اللَّهِ الرَّحْمَنِ الرَّحِيم

Oleh: Bagus Suminar

Wakil Ketua ICMI Jatim, Tim Soft Skills mutupendidikan.com

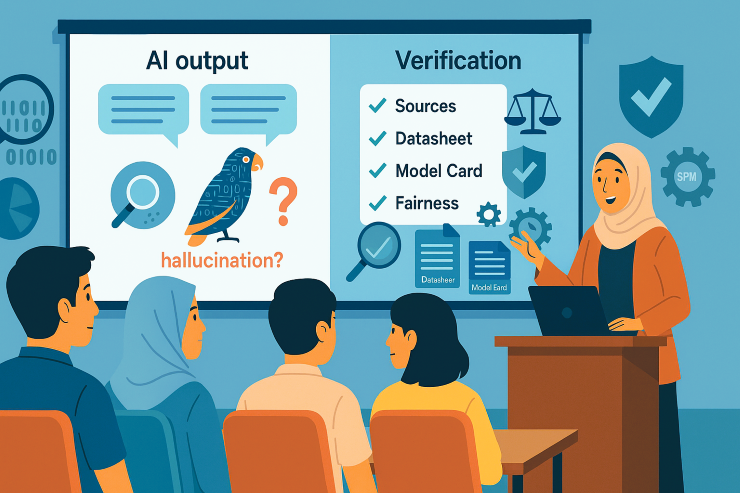

“AI bisa bias dan halu. Kampus perlu literasi AI: verifikasi sumber, disclosure, audit data agar cepat tetap adil, tepercaya, dan bertanggung jawab.”

Minta AI merangkum fenomena, jawabannya mengalun mantap—seolah menyaksikan pakar bicara di panggung. Tapi coba tanya sekali lagi, ubah sedikit konteksnya, cek referensinya, beberapa “fakta” tiba-tiba bergeser. Halusinasi bekerja halus: yang berubah bukan hanya isi, tapi juga keyakinan kita. Kampus perlu mengajarkan remnya—cara mengecek sumber, membedakan kefasihan dan kebenaran, dan menuliskan jejak verifikasi.

Masalahnya, di kelas yang serba cepat, kita sering memaklumi “kefasihan” sebagai kebenaran. Mahasiswa datang dengan ringkasan yang rapi, dosen senang karena diskusi terdorong, lalu cek dua sitasi kunci, ternyata halu, tak pernah ada. Di titik itu, kita mulai sadar literasi AI menjadi sangat penting. Kita perlu kompas. Kita butuh “bahasa kerja” yang sama untuk bertanya hal mendasar: data apa yang dipakai model? siapa yang terwakili dan siapa yang tidak? seberapa valid ia untuk topik ini?. Tanpa itu, efisiensi hanya jadi jalan pintas menuju kerancuan dan kebingungan baru.

Untuk menata ulang cara pandang, kita bisa menumpukan pijakan pada tiga penopang yang sederhana tapi tajam. Pertama, kacamata Algorithmic Bias dan Value Sensitive Design (kerangka oleh Batya Friedman & Helen Nissenbaum). Intinya, bias bukan sekadar “AI-nya nakal”, melainkan jejak nilai yang menempel pada data, desain, dan konteks sosial. Ketika kita bertanya tentang tokoh ilmiah Indonesia lalu yang keluar deretan nama asing, itu bukan kebetulan. Itu cermin dari korpus yang timpang dan sinyal popularitas global yang lebih keras suaranya. Riset Joy Buolamwini tentang bias di pengenalan wajah menunjukkan: ketika representasi data timpang, akurasi jatuh untuk kelompok tertentu. Logika yang sama berlaku pada model bahasa di kelas—jika korpusnya miskin konteks Indonesia, keluaran mudah miring: nama ilmuwan lokal terabaikan, stereotip tak sengaja muncul, dan ‘fakta’ bergeser.

Prinsip yang sama berlaku di kelas: kalau bahan bacaan kita miskin nama Indonesia atau literatur daerah, keluaran yang miring itu bukan “kesalahan AI”, melainkan cermin dari bahan baku. Literasi AI berarti mengajarkan mahasiswa membongkar sumber ketimpangan semacam ini, lalu merancang mitigasinya: memperkaya rujukan lokal, menyeimbangkan contoh, mengubah cara memancing keluaran, dan menuliskan batas-batas interpretasi dengan jujur.

Penopang kedua adalah FAccT—fairness, accountability, transparency (komunitas riset—tiga prinsip yang jadi kompas). Fairness mengajak kita menilai apakah keluaran AI adil lintas kelompok, bahasa, dan konteks; jangan sampai tugas atau evaluasi ikut menumpang bias. Accountability menegaskan penanggung jawab tetap manusia: dosen saat merancang tugas dan standar, mahasiswa saat mengeksekusi, memeriksa, dan melaporkan. Transparency menuntut keterbukaan tanpa drama: alat apa yang dipakai, versi berapa, di tahap mana, dan seberapa besar pengaruhnya pada hasil.

Di titik ini, pemikiran Arvind Narayanan (Profesor ilmu komputer di Princeton) berguna sebagai rem kognitif: banyak klaim tentang AI itu seperti “snake oil”—tampak mujarab untuk apa saja, padahal hanya andal pada tugas tertentu dan mudah berhalusinasi di tempat lain. Maka keluaran model sebaiknya diperlakukan sebagai hipotesis yang perlu diuji dengan sumber primer, bukan kebenaran siap saji. Dengan FAccT, kita punya kompas untuk memutuskan kapan percaya, kapan memeriksa lebih dalam, dan kapan menolak hasil yang terlalu mulus.

Penopang ketiga adalah toolkit yang membumi: Datasheets for Datasets (Timnit Gebru dkk.) dan Model Cards (Margaret Mitchell dkk.). Kita sering berdiskusi tentang AI di awan-awan konsep, padahal banyak masalah terjadi di detail. Dataset tanpa asal-usul jelas, lisensi abu-abu, representasi timpang, metrik yang hanya memuja akurasi; semua itu mendorong keputusan yang terasa rapi namun rapuh. Datasheets memaksa kita menuliskan dari mana data dikumpulkan, untuk apa, siapa yang dilibatkan, bias apa yang mungkin muncul, dan apa batas aman pemakaiannya.

Model Cards mendorong pengakuan jujur: kapan model bekerja baik, di konteks mana ia rapuh, metrik apa yang dipakai, dan risiko apa yang harus dibaca lebih dulu. Di kelas, praktik ini tidak perlu rumit. Satu halaman datasheet untuk dataset tugas, satu halaman model card mini untuk alat yang digunakan, keduanya diunggah bersama laporan. Efeknya besar: mahasiswa belajar bahwa kerapihan laporan bukan soal gaya bahasa semata, melainkan keterlacakan data dan keputusan.

Sekarang bayangkan keseharian kampus dengan kacamata ini. Tugas tidak langsung menuntut hasil akhir yang bagus, tetapi memecah proses menjadi beberapa lompatan kecil. Minggu pertama, mahasiswa boleh memancing ide dengan model bahasa, namun hanya membawa poin kasar—tanpa sitasi. Minggu kedua, mereka mencari sumber primer untuk mendukung atau membantah poin tadi, menuliskan catatan verifikasi, dan menandai bagian yang keliru atau terlalu umum. Minggu ketiga, barulah mereka menyusun naskah utuh, lengkap dengan disclosure dan lampiran log singkat: prompt kunci, versi model, dan tahap penggunaan. Di akhir, dosen menilai bukan hanya kefasihan, tetapi jejak pikir: bagaimana bukti ditemukan, bagaimana klaim dipersempit, bagaimana bias dikenali dan diatasi. Jika ingin lebih hidup, kelas bisa memainkan red teaming terarah: kelompok mahasiswa diminta memancing keluaran yang bias pada topik sensitif—tanpa data pribadi—lalu menuliskan strategi mitigasi dan refleksi etisnya.

Kebijakan SPMI perlu terus di-update, menyusul agar budaya ini awet. Masukkan literasi AI ke SPMI (Sistem Penjaminan Mutu Internal—siklus PPEPP), bukan sebagai poster satu kali, melainkan standar berulang: kategori penggunaan Boleh, Terbatas, Dilarang; template disclosure yang jelas; rubrik penilaian yang memberi bobot besar pada proses verifikasi dan dokumentasi.

Pastikan komite etik punya checklist AI untuk riset yang menyentuh manusia atau data sensitif. Perbarui daftar alat rekomendasi setiap semester, utamakan yang menghormati privasi, menyediakan kontrol versi, dan memudahkan penyimpanan jejak kerja. Kebijakan yang jelas bukan mengekang kreativitas; ia menyediakan lantai yang kuat agar kreativitas punya pijakan yng kokoh.

Kadang yang paling sulit justru sikap kita sendiri. Ketika mesin terasa praktis, tangan refleks menekan tombol oke, perpikir kritis pelan-pelan mundur. Padahal keadilan lahir dari kerja memeriksa, bukan dari kenyamanan. Di titik ini, literasi AI bertemu pendidikan karakter. Kita perlu menormalisasi kalimat, “bagian perapian bahasa dibantu alat, isi diverifikasi manual, rujukan berikut adalah sumber primer yang saya baca.” Bukan untuk pencitraan, melainkan untuk memberi tahu pembaca di mana mereka bisa percaya dan di mana mereka perlu cek dan menguji ulang.

Di ujung semua alat dan metode, kita kembali pada peringatan yang sederhana tapi tegas: “Janganlah kamu mengikuti apa yang kamu tidak mempunyai ilmu tentangnya; sesungguhnya pendengaran, penglihatan, dan hati—semuanya akan diminta pertanggungjawaban.” (QS Al-Isrā’: 36). Artinya, setiap ringkasan yang tampak rapi, setiap angka yang terlihat meyakinkan, harus lahir dari pengetahuan yang diuji. Di kampus, artinya setiap keluaran AI disertai catatan verifikasi, keputusan dicatat agar bisa diaudit, dan batas kemampuan model ditulis jelas—bukan dipercaya begitu saja karena praktis.

Lalu kita kunci dengan disiplin tabayyun: “Jika datang kepadamu orang fasik membawa suatu berita, maka telitilah.” (QS Al-Ḥujurāt: 6). Di era AI, berita itu bisa berupa kalimat yang fasih atau sitasi yang tampak valid, tapi kita tetap wajib memeriksa. Biarkan mesin berlari cepat, sementara kita menjaga rem pengetahuan: cek sumber, revisi klaim, tulis apa adanya. Begitu cara kecepatan bertemu kebenaran—dan ilmu yang kita ajarkan bukan hanya membuat pintar, tetapi juga adil dan dapat dipercaya. Stay Relevant!

Disclosure:

- Artikel ini disunting dengan bantuan alat AI untuk perapian bahasa; verifikasi fakta dan tanggung jawab isi dilakukan penulis.

- Ilustrasi dibuat dengan bantuan alat AI berlisensi; ide, kurasi, dan finalisasi oleh penulis/editor.

Instagram: @mutupendidikan